Огромную роль в продвижении играет файл robots в WordPress, да и на любом сайте. Одной строчкой можно полностью выкинуть ресурс из индекса, либо грамотно управлять поведением поискового робота, чтобы сократить время на индексацию и показать только необходимый контент.

Не путайте с meta name=”robots” в той же пагинации, который прописывается в коде и в основном управляет атрибутами noindex и nofollow.

Правильный общий файл robots txt для WordPress

Покажу какой использовать лучший, универсальный и правильный пример robots txt для всех сайтов WordPress, он сделает базовые настройки, остальные директивы вы должны вносить сами на блог.

User-agent: *

Disallow: /wp-

Disallow: /tag/

Disallow: */trackback

Disallow: */page

Disallow: /author/*

Disallow: /template.html

Disallow: /readme.html

Disallow: *?replytocom

Allow: */uploads

Allow: *.js

Allow: *.css

Allow: *.png

Allow: *.gif

Allow: *.jpg

Sitemap: https://site.ru/sitemap.xmlВ примере вместо site вставляем домен своего сайта. Далее разберемся как оперировать командами. Все просто:

- Disallow запрещает роботам сканировать и выкачивать данные из указанных директорий.

- Allow разрешает проверять составляющие ресурса, в основном тут открывают только картинки и остальные медиафайлы.

- Sitemap путь до карты в формате xml, чтобы роботу не искать самому, тут указывается ее точный адрес.

Набора данных стандартных команд хватит для 99% задач в WordPress. Например, есть папка с файлами, которые не должны попасть в индекс, просто проставляете с помощью относительного адреса путь до нее с командой disallow. Далее можете составить свои команды, но будьте осторожны не закройте доступ к важной информации.

Существую устаревшие директивы: Host – указывает на главное зеркало, сейчас это определяется автоматически по редиректу, Crawl-delay и Clean-param – показывает сколько времени можно находится роботу на странице и разрешение на выкачку дубликатов. Их не нужно использовать, лучший исход ничего не произойдет, худший возможны проблемы с другими ПС отличными от Яндекса и Google.

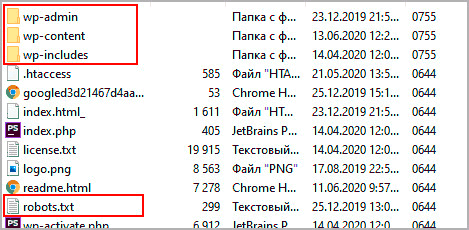

Где лежит robots txt

Независимо от CMS, разработки и вида, robots txt должен лежать в корне сайта, то есть в папке откуда загружается главная. В WordPress это папка, где находятся каталоги wp-admin, wp-content и wp-includes.

Часто бывает, что пользователи не могут найти, почти в 100 процентах случаев это виртуальные файлы. То есть при запросе url в адресной строке браузера он создается автоматически, скорее всего в каком-то плагине, физически на хостинге его не увидеть.

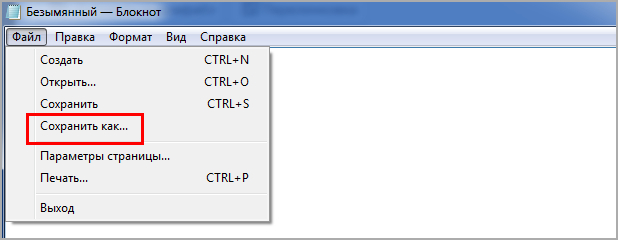

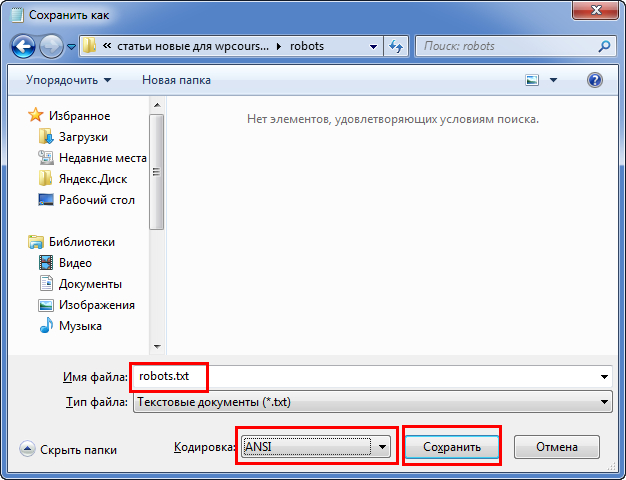

Как создать robots

Чтобы создать robots советую применять простой блокнот. Для начала создадим новый документ.

Далее помещаем содержимое, можете скопировать из поля выше, каждое правило с новой строчки, это важно, возможно при копировании все будет в одну строку.

Чтобы установить tuj на сервере, придется создать FTP соединение. Скриншот был выше, показывал где он должен располагаться.

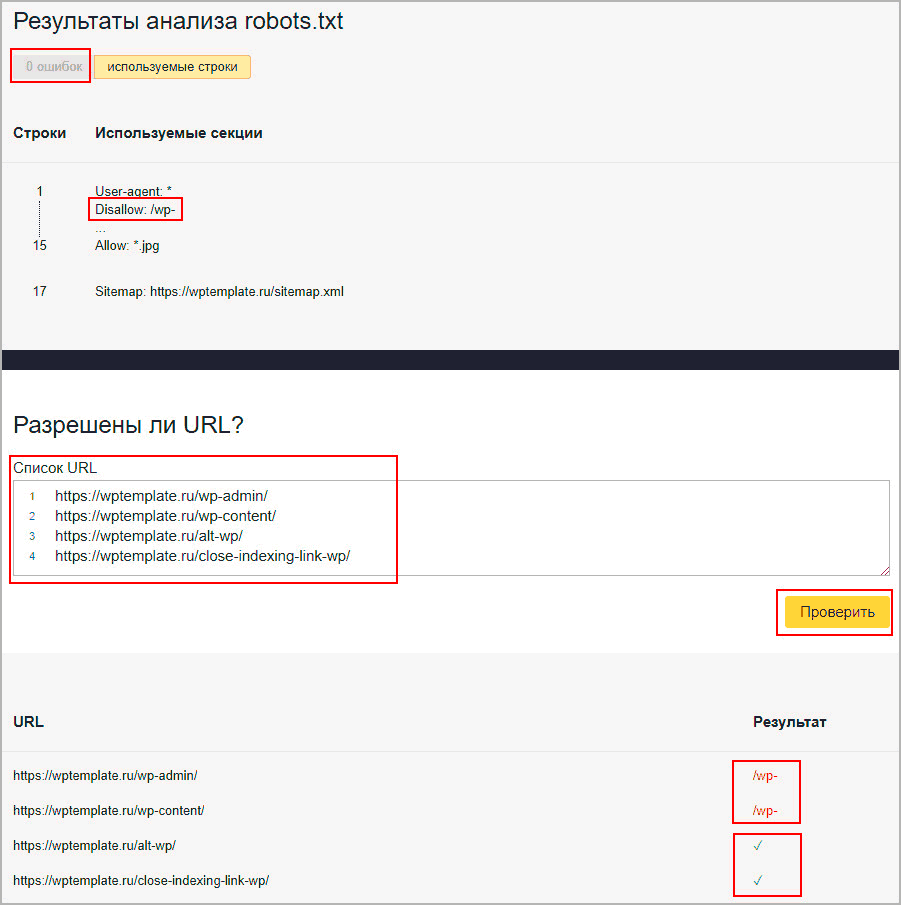

Проверка работы в валидаторе Yandex

Если сайт зарегистрирован в сервисе для вебмастеров от Яндекса, то доступен инструмент проверки работы. В панели переходим Инструменты – Анализ robots txt. Вводим страницы для проверки, в первые две я ввел каталоги, которые начинаются с wp- (напомню, они запрещены к индексации), а другие две это просто статьи.

- Смотрим, чтобы ошибок не было.

- Вспоминаем что у нас есть

Disallow: /wp-. - Вводим url для проверки.

- Видим, что первые две запрещены к сканированию, потому что начинаются с wp-.

- Вторые две разрешены и стоят зеленые галочки.

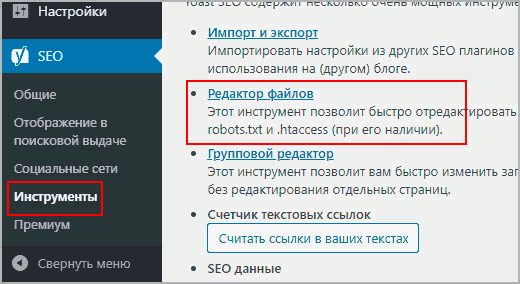

Создать и отредактировать robots в плагине Yoast

В Yoast есть отличный инструмент формирующий robots txt, причем он создает файл физически, роботс появится на вашем хостинге, если бы вы его создавали самостоятельно. Причем после деактивации Yoast файл не стирается с хостинга, это крутое дополнение, потому что остальные плагины SEO в WordPress, делают виртуальные копии.

На следующей странице в вордпресс будет предложение создать robots, если нет, или отредактировать при его наличии. Копируйте код представленный выше. Так вам не придется скачивать и разбираться с удаленным соединением, а просто изменить из админки.

Не советую применять функции создания в плагине All in SEO Pack (AIOSP), других дополнениях и онлайн сервисами, потому что интерфейс формирования, очень не удобный, и создается именно виртуальный элемент, то есть после деактивации роботс пропадет.

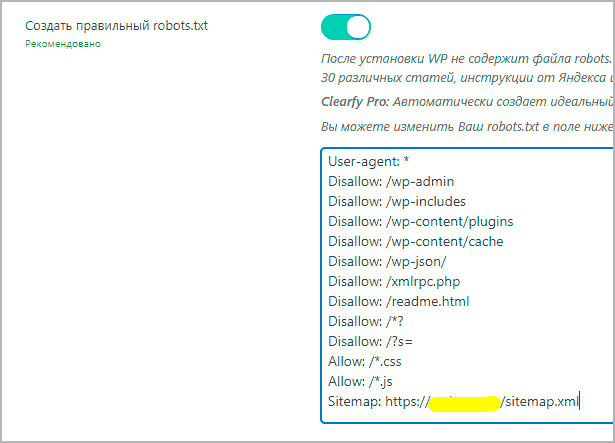

Clearfy PRO – автоматический и правильный robots

В одной из настроек Clearfy является создание robots txt, причем он абсолютно идентичен, представленному в статье, с возможностью изменить команды.

Отмечу что создание правильного роботс, это только одна из 50 разнообразных фишек, по улучшению WordPress, например, расстановка ALT у изображений.

Идеальный robots для WooCommerce в WordPress

Если используете плагин интернет магазина WooCommerce, то советую внести несколько дополнительных строк в robots txt, чтобы адреса оформления заказов, корзины и остальные технические документы не попадали в индекс поисковых систем, и тогда получим идеальную инструкцию для поведения роботов в магазине под управлением WordPress.

Disallow: /cart/

Disallow: /checkout/

Disallow: /*add-to-cart=*

Disallow: /my-account/На этом закончим урок, мы разобрались где хранится, как добавить и читать, что написано в robots txt для движка WordPress.

Вот своей статье я как раз подробно описал то, что если открыть uploads для всех ботов, то в индексе появляются загруженные PDF и прочие текстовые файлы. А в яндекс вебмастере, в отчете “Исключенные страницы” появляются сообщения об ошибке при индексировании картинок, мол содержимое не поддерживается. Прежде чем писать и давать советы, сообщения GSC и ЯВебмастера пробовали анализировать?

Здравствуйте! У нас все норм 😉